El desarrollo de una nueva interfaz cerebro-computadora (BCI) logró que una mujer con parálisis recuperara la capacidad de hablar utilizando su propia voz. El método decodifica señales cerebrales y, mediante un modelo de inteligencia artificial de texto a voz, las transforma en audio casi en tiempo real.

“Escuchar su propia voz casi en tiempo real aumentó su sensación de encarnación”, afirmó Gopala Anumanchipalli, profesor de la Universidad de California, al describir el impacto de este avance, detallado por Popular Science. El hito representa un salto en la integración de BCI e inteligencia artificial para restituir la comunicación oral en personas sin habla.

El sistema intercepta señales neuronales y las convierte en frases audibles con una latencia inferior a 80 milisegundos, lo que facilita conversaciones fluidas y naturales. A diferencia de métodos tradicionales, usualmente lentos y poco naturales, la nueva tecnología emplea un enfoque comparable a un traductor automático avanzado, pero descifra la actividad cerebral en vez de traducir idiomas. “Nuestro enfoque de transmisión brinda la misma capacidad de decodificación rápida de voz de dispositivos como Alexa y Siri a las neuroprótesis”, explicó Anumanchipalli.

El caso de Ann

El equipo de investigación trabajó con Ann, una mujer que perdió la capacidad de hablar tras un accidente. Para capturar la información necesaria, los científicos implantaron una matriz de electrocorticografía (ECoG) de 253 canales sobre la región cerebral encargada del control motor del habla. Durante las pruebas, Ann leía frases proyectadas en una pantalla; el sistema registraba la actividad cerebral correspondiente. El vocabulario del experimento incluyó 1.024 palabras, lo que permitió a los investigadores comenzar a descifrar sus pensamientos y convertirlos en palabras en tiempo real.

Funcionamiento del implante

El coautor del estudio, Cheol Jun Cho, explicó que el sistema “intercepta señales donde el pensamiento se traduce en articulación y en el control motor”. Según sus palabras, lo que se decodifica ocurre después de que la persona decide qué decir y cómo mover los músculos del tracto vocal. Esta precisión representa un salto respecto a tecnologías previas, como la que empleaba Stephen Hawking, que generaba entre 10 y 15 palabras por minuto debido a la lentitud de la interfaz.

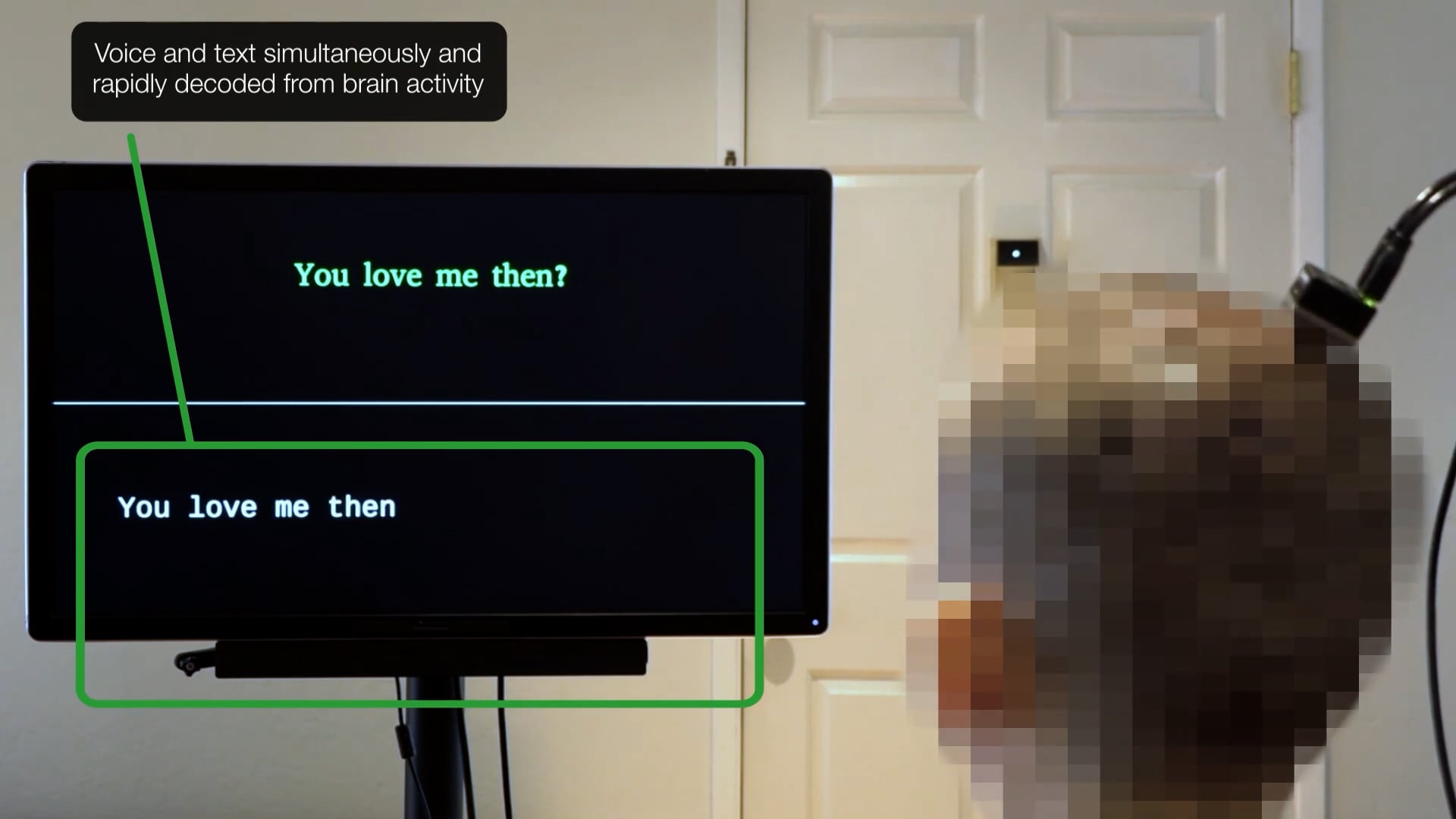

El avance fue posible gracias a modelos de aprendizaje automático capaces de entrenar sintetizadores de voz con grabaciones previas del paciente. En el caso de Ann, el sistema utilizó registros de su voz anteriores al accidente, logrando una síntesis personalizada y natural. En una demostración clínica, Ann observó la frase “tú me amas” en la pantalla y, segundos después, el modelo de IA reprodujo esas palabras con su timbre original. Posteriormente, pudo repetir frases como “entonces lo hiciste” y “¿Dónde conseguiste esto?”, mostrando satisfacción al escuchar una voz reconocida como propia.

Empresas líderes impulsan la neurotecnología

El campo de las BCI experimenta una expansión más allá de los laboratorios. Popular Science destaca que Neuralink, fundada por Elon Musk en 2016, implantó su dispositivo en tres pacientes humanos. El primero, Noland Arbaugh, cuadripléjico de 30 años, consiguió controlar un mouse de computadora y jugar videojuegos solo con sus pensamientos. Neuralink mejoró su sistema con más electrodos, lo que, según la empresa, incrementa el ancho de banda y la duración de la batería. Asimismo, la empresa recibió una designación especial de la Administración de Alimentos y Medicamentos (FDA) para desarrollar un dispositivo enfocado en restaurar la visión.

Otra firma destacada, Synchron, demostró que un paciente con esclerosis lateral amiotrófica (ELA) podía manejar un visor de realidad mixta Apple Vision Pro únicamente con señales neuronales. “Usar este tipo de realidad aumentada es tan impactante que puedo imaginar lo que supondría para otros en mi situación o para quienes han perdido la capacidad de participar en su vida diaria”, señaló Mark, paciente de Synchron. “Puede transportarte a lugares que nunca pensaste volver a ver o experimentar”.

Si bien Estados Unidos lidera el sector, otras regiones muestran avances destacados. Según Popular Science, la empresa china NeuCyber NeuroTech implantó su chip BCI semiinvasivo en tres pacientes en el último mes y prevé diez intervenciones adicionales antes de finalizar el año, según Reuters.

A pesar de los progresos, los investigadores reconocen los retos pendientes antes de alcanzar conversaciones cotidianas completamente naturales para personas que han perdido el habla. El equipo en California concentra su trabajo en perfeccionar los métodos de captura y los modelos de IA para reflejar mejor matices de tono y entonación, factores esenciales para transmitir emociones. Además, buscan acortar todavía más la latencia del sistema. “Eso es trabajo en curso, para ver hasta qué punto podemos decodificar realmente estas características paralingüísticas a partir de la actividad cerebral”, concluyó Kaylo Littlejohn, estudiante de doctorado y coautor del estudio.

BCI personalizada, conversación fluida y emociones en la voz: la ciencia abre nuevas posibilidades para la comunicación en personas con parálisis.