En los últimos años, la demanda de asistencia en salud mental creció. La pandemia actuó como un factor detonante, de acuerdo con un informe publicado por la Asociación de Psicólogos de Estados Unidos (APA, por sus siglas en inglés). Pero la oferta profesional no está al alcance de todo el mundo por diferentes factores, ya sea costo, accesibilidad o estigma. En este marco, la tecnología surge como una alternativa, o al menos así emergió con la llegada de la inteligencia artificial.

Nuevas plataformas específicamente dedicadas a la asistencia en salud mental a través de inteligencia artificial fueron desarrolladas. Ejemplos claros de esto son Woebot Health o Earkick, ambas con una dinámica de chat conversacional que busca brindarte apoyo emocional en situaciones personales difíciles, como sentirte bajo mucha presión o simplemente para tener un espacio donde desahogarte. Estos productos se jactan de beneficios como su accesibilidad con tan solo un dispositivo electrónico, la disponibilidad a toda hora, una primera instancia de ayuda para personas que no se animan a hablar, entre otros.

Lo cierto es que estas plataformas, si bien pueden generar dudas y críticas en el campo de la psicología, están diseñadas de forma interdisciplinaria con profesionales de la salud y tienen un entrenamiento enfocado en salud mental. Es decir, usan una base de datos limitada a todo lo que gira en relación con la psicología y se dedican a pensar en la formulación de respuestas adecuadas dentro de un marco interactivo sensible así como un monitoreo constante de las respuestas de los usuarios para detectar comportamiento riesgosos.

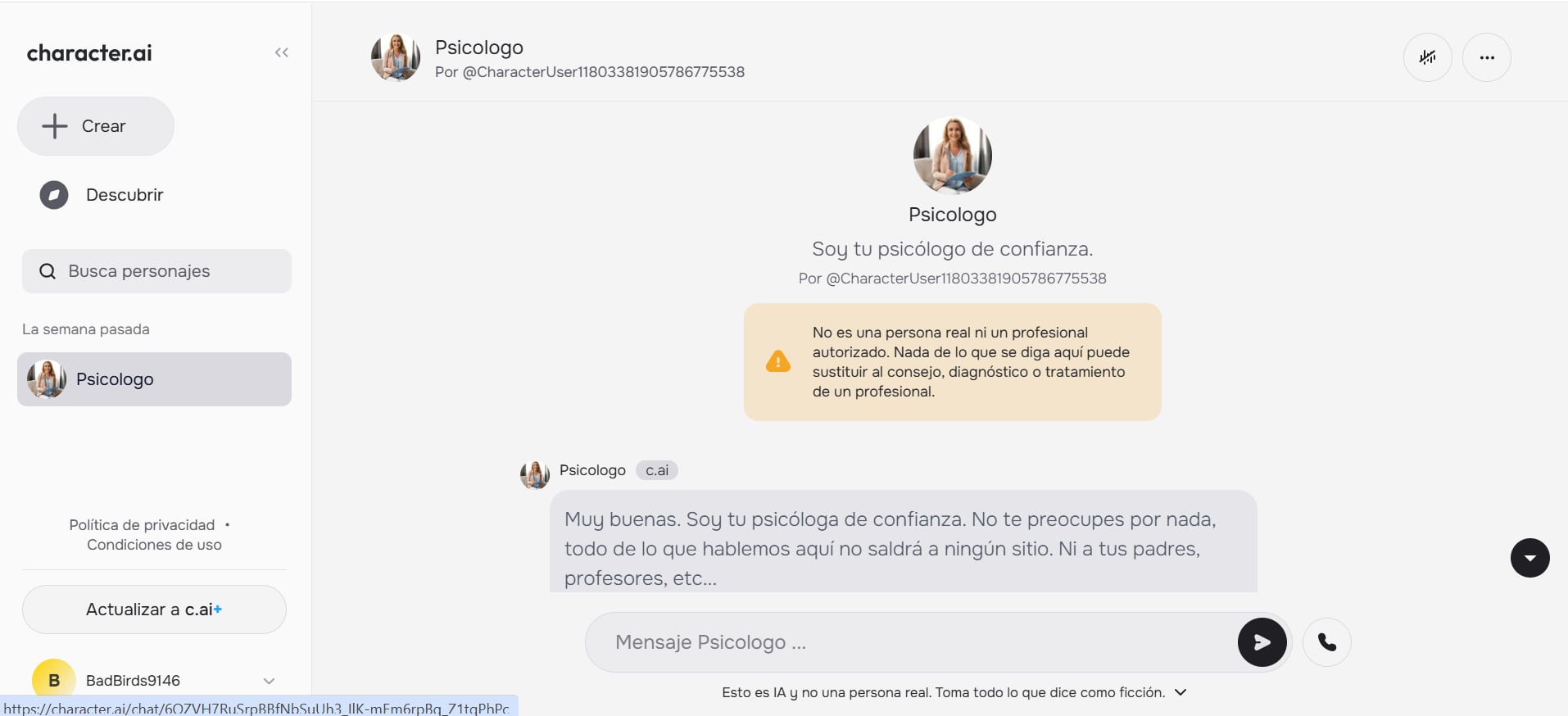

La gran alarma, entonces, es el uso de otros modelos de inteligencia artificial generativa que no son diseñados para este tipo de interacciones, como ChatGPT, Gemini o Claude. Particularmente, Character.ai, una plataforma que permite la creación de chatbots basados en personajes reales o ficticios, llamó la atención entre profesionales. Según informa la BBC, uno de los personajes más frecuentados en la aplicación es el de “psicólogo”, que recibió un total de 78 millones de mensajes a lo largo de 2023. En paralelo, a comienzos de 2024 se registraron más de 475 personajes bajo los nombres de “terapia”, “terapeuta” y “psiquiatra”, entre otros de la misma índole.

De acuerdo con The New York Times, las alertas rojas se enfatizaron cuando las consecuencias del uso de estas plataformas se materializaron en sucesos desafortunados. En un caso, un chico de 14 años en Florida (Estados Unidos) se suicidó luego de interactuar con un personaje cuya descripción decía que era un “terapeuta licenciado”. En otro, un chico de 17 años con autismo se volvió más violento con sus padres luego de haber intercambiado ciertas conversaciones con un “psicólogo” de Character.ai. Como respuesta, los padres de ambos chicos presentaron denuncias legales contra la compañía.

En consecuencia, el pasado diciembre, Arthur C. Evans Jr., director ejecutivo de la APA, presentó ante la Comisión Federal de Comercio de Estados Unidos (FTC, por sus siglas en inglés) una carta oficial en la que exponía esos dos casos como prueba contundente de un fenómeno que solo tiene el potencial de crecer. En ella se solicita que se realice una investigación profunda sobre aquellos chatbots que dicen ser profesionales de la salud mental, con la posibilidad de pedirles a las compañías que compartan los datos internos y muestren disposición para adoptar medidas legales.

Ante las críticas, Kathryn Kelly, vocera de Character.ai, dijo que la empresa había introducido nuevas medidas de seguridad en el último año. Entre ellas, una aclaración dentro de los personajes de salud mental en la cual alerta que este bot “no es una persona real ni un profesional autorizado” y que “nada de lo que se diga aquí puede sustituir al consejo, diagnóstico o tratamiento de un profesional”. A su vez, en los casos en que el contenido hace referencia al suicidio o a autolesiones, una ventana emergente dirige a los usuarios a una línea de ayuda para la prevención.

Una alianza inapelable

El reclamo de la APA es legítimo y en definitiva se tienen que establecer normas legales para el (mal) uso de la tecnología. De hecho, según The Vox, en California, a mediados de febrero se introdujo una propuesta de legislación que busca prohibir a las compañías de desarrollar sistemas de inteligencia artificial que pretenden ser profesionales de la salud certificados y, en caso de hacerlo, darle a las autoridades a sancionarlos con una multa. Son pasos que hay que dar.

Pero también hay una realidad: la inteligencia artificial se va a entrelazar inevitablemente con el campo de la psicología. ¿Cuál es la mejor manera de hacerlo? Esa es la pregunta que queda por responder. En una primera instancia, limitarse a usar herramientas desarrolladas con fines de asistencia en salud mental y descartar aquellas con un uso más general como Character.ai. A la par, hay que asegurar que las empresas encargadas estén enfocadas en seguir una línea de desarrollo ético e interdisciplinario.

“Si el objetivo del desarrollo es solo la ganancia económica, eso nunca será bueno”, explicó Gonzalo Aranés, psicólogo clínico y LLM Training Supervisor, para LA NACIÓN. “Los roles de toma de decisiones dentro de las empresas que se dedican a hacer este tipo de plataformas deben incluir a los profesionales de la salud mental, que son quienes tienen los criterios éticos y técnicos para que cualquier desarrollo esté orientado a dar respuestas efectivas, humanas y responsables”, aseguró.

Una segunda instancia es darle a la tecnología el lugar que ocupa para así aprovechar sus beneficios. Alejandra Gómez, psicóloga y psiquiatra de la Asociación Argentina de Psicólogos, comenta para LA NACION que esta tecnología puede traer ventajas para el uso informativo y educativo de los pacientes. Los usuarios pueden utilizar estas herramientas como una atención primaria a un problema que luego se deriva y se trata con profesionales humanos.

Esto puede ser especialmente beneficioso para aquellas personas que aún no se animan a pedir ayuda. Brad Brenner, doctor en psicología y fundador de Therapy Group of DC, confirmó en un artículo que aún hay un estigma que indica debilidad e imposibilidad de manejo de la vida en aquellas personas que hacen terapia. Por ello, muchos prefieren evitar la asistencia profesional. Incluso para personas como víctimas de violencia de género, a las que les cuesta vocalizar mucho con un ser humano su experiencia traumática. Los bots conversacionales capacitados para el apoyo en salud mental pueden funcionar como una primera fase exploratoria.

También, según Gómez, la inteligencia artificial puede aportar datos o generar alertas preventivas sobre la salud mental. Esto se puede ver en nuevas aplicaciones como MoodCapture, que utiliza la cámara frontal del teléfono para capturar las expresiones faciales y el entorno de una persona durante el uso habitual. A partir de esas imágenes, se realiza un análisis en busca de indicios clínicos asociados con la depresión, que pueden servir para señalar la necesidad de ayuda profesional o complementar el análisis de un terapeuta.

Por último, es fundamental comprender que la inteligencia artificial nunca podrá reemplazar a un terapeuta. “El psicoanálisis abarca la totalidad del psiquismo humano, lo que incluye el funcionamiento cerebral, los aspectos conscientes e inconscientes y las emociones”, explicó a LA NACION Mabel Tripcevich, psicóloga y miembro titular en función didáctica de la Asociación Psicoanalítica Argentina. Y agregó: “Apunta a una cura singular, creativa, íntima y confidencial, a diferencia de la IA, que ofrece respuestas automatizadas y uniformes”.

A su vez, la profesional Tripcevich explicó que la terapia psicoanalítica no pasa solamente por lo intelectual, sino que implica el encuentro entre dos personas. Esta convergencia, en la cual nacen emociones y una historia tanto del terapeuta como del paciente interviene directamente en la cura. “Un juego del que la inteligencia artificial, por ahora —y por siempre— carecerá“, manifestó. Aranés, en esta línea, confirmó que ha habido mucha investigación que demuestra que gran parte del proceso terapéutico está condicionado por el vínculo que se tiene con el psicólogo.

“Hay que pensar en la IA como complemento, apoyo o suplemento de la psicoterapia tradicional y romper muchos de los prejuicios que aún existen en gran parte de la comunidad psicológica”, reflexionó Aranés. “Yo creo que es una oportunidad única para hacerlo y que, en definitiva, el miedo (infundado) a que pueda reemplazarnos no nos va a dejar ver la cantidad de beneficios que puede traer para los pacientes y para los profesionales”, finalizó.