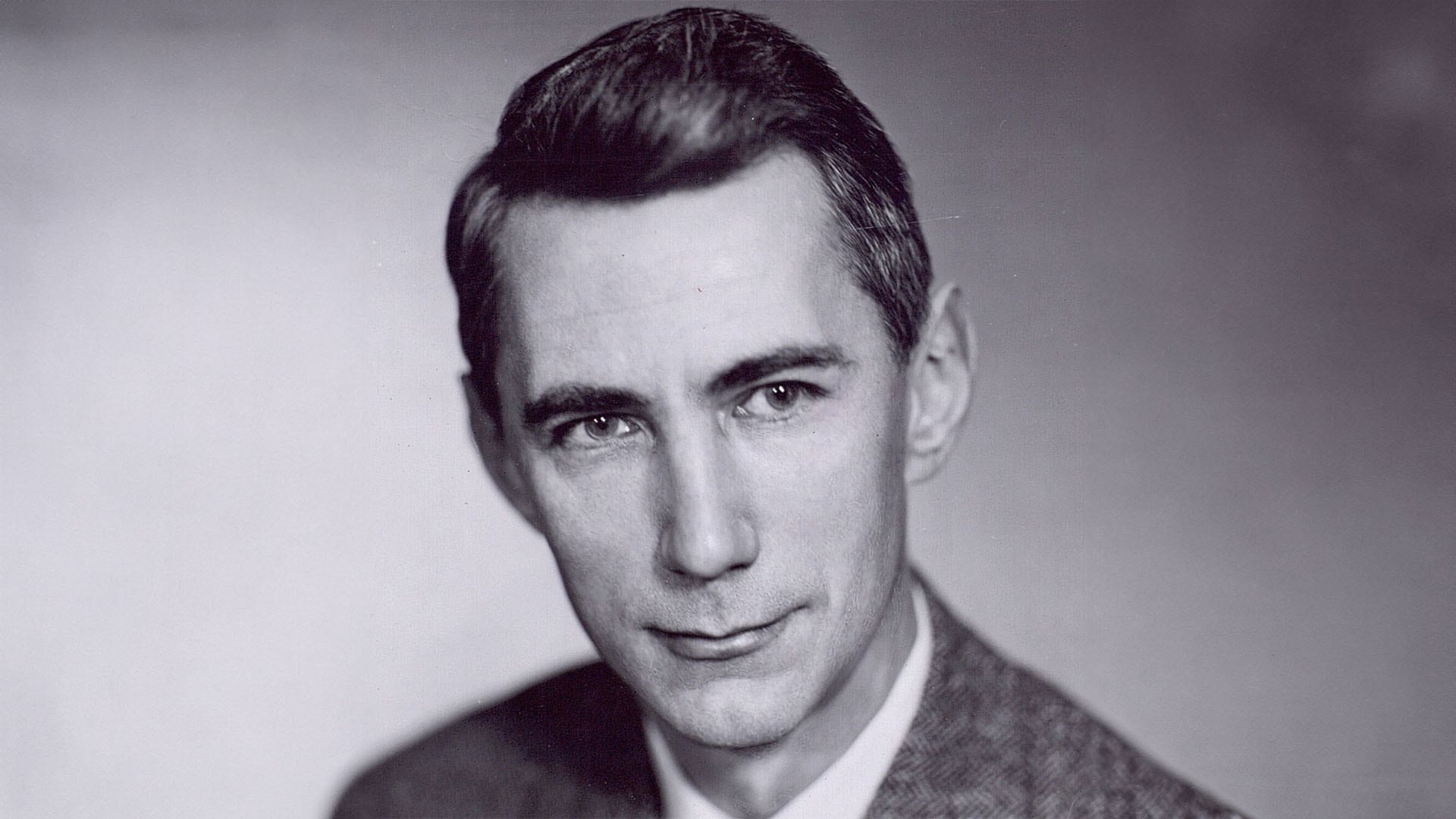

Claude Elwood Shannon nació el 30 de abril de 1916 en Petoskey, Michigan. Desde temprana edad, mostró una curiosidad insaciable por los mecanismos que lo rodeaban. En su infancia, no solo se dedicaba a reparar radios, sino que también construía juguetes y experimentaba con las piezas de tecnología disponibles en su entorno.

Esta inclinación por la ingeniería y las matemáticas lo llevaría a una carrera que cambiaría el curso de la historia de la computación y las telecomunicaciones.

Según Spectum, durante su niñez y adolescencia, ya era evidente que la mente de Shannon iba más allá de lo convencional

Shannon estudió ingeniería eléctrica y matemáticas en la Universidad de Michigan, y fue en la Universidad de Princeton donde profundizó sus conocimientos y obtuvo su doctorado en matemáticas en 1940.

Durante su tiempo en Princeton, elaboró una tesis doctoral que cambiaría para siempre la teoría de los circuitos eléctricos.

En su trabajo, “Un análisis simbólico de los circuitos de relés y de conmutación”, Shannon aplicó la lógica booleana, formulada por el matemático británico George Boole, para modelar operaciones matemáticas en circuitos eléctricos.

Esta tesis, publicada en 1937, fue tan revolucionaria que muchos expertos la consideran la más importante de todos los tiempos.

Su descubrimiento proporcionó la base para la programación de computadoras y sentó las bases de la computación digital tal como la conocemos hoy

Después de obtener su doctorado, Shannon se unió a los Laboratorios Bell, donde su trabajo lo llevaría a desarrollar la teoría matemática de la criptografía durante la Segunda Guerra Mundial.

En ese contexto, Shannon transformó la criptografía, hasta entonces un arte, en una ciencia rigurosa, creando teorías que permitían codificar y descifrar mensajes de forma segura y precisa.

Según Spectrum, entre sus logros más destacados en esa área se encuentra el artículo “Una teoría matemática de la criptografía”, en el que propuso una forma de proteger los mensajes digitales mediante el uso de claves y códigos, algo que sería esencial para las comunicaciones modernas.

Sin embargo, la contribución más radical de Shannon a la ciencia vino con la publicación de su artículo “A Mathematical Theory of Communication” en 1948.

En este artículo, presentó su teoría de la información, que sentó las bases para la manera en que entendemos la transmisión de datos en la actualidad.

Introdujo la noción de “entropía de la información”, un concepto tomado de la física que se refiere a la incertidumbre o imprevisibilidad de los datos transmitidos a través de un canal de comunicación.

Además, fue Shannon quien definió el “bit” como la unidad básica de información, una unidad binaria de 0 o 1 que se convertiría en el bloque fundamental de toda la computación digital.

Aunque su trabajo era reconocido en el mundo académico, Shannon nunca buscó la fama. De hecho, a lo largo de su carrera se alejó activamente de la atención pública. Como señala Rob Goodman, coautor de la biografía A Mind at Play, Shannon prefería trabajar en el anonimato, con su mente enfocada en problemas complejos y en la creación de nuevos dispositivos.

Uno de sus inventos más singulares fue el “ratón mecánico” llamado “Theseus”, un dispositivo capaz de encontrar su camino a través de un laberinto mediante ensayo y error, uno de los primeros ejemplos de lo que hoy llamaríamos inteligencia artificial.

Además, desarrolló una máquina para jugar ajedrez, entre otras invenciones que, aunque no siempre eran prácticas, mostraban su extraordinaria capacidad para resolver problemas mediante la tecnología.

Shannon también era conocido por su sentido del humor y su carácter excéntrico.

Según sus colegas, que hablaron con la revista Spectrum, se paseaba por los pasillos de los Laboratorios Bell montado en un monociclo mientras hacía malabares con cuatro pelotas. Esta actitud lúdica contrastaba con la seriedad de su trabajo intelectual, pero era una expresión más de su forma única de interactuar con el mundo.

A lo largo de los años 50 y 60, Shannon continuó desarrollando innovaciones tecnológicas, muchas de las cuales anticiparon avances que no se producirían hasta varias décadas después.

Entre estos dispositivos se encontraba una “máquina que leía la mente”, y una calculadora que utilizaba números romanos para realizar cálculos.

A pesar de su relativa falta de interés en las aplicaciones prácticas de sus creaciones, su capacidad para imaginar dispositivos complejos y divertidos nunca dejó de asombrar a sus colegas.

“Hago lo que me sale naturalmente y la utilidad no es mi objetivo principal”, decía él, una declaración que subraya su enfoque único hacia la ciencia y la tecnología

Shannon murió el 24 de febrero de 2001 a los 84 años, dejando atrás un legado monumental que sigue vigente en la tecnología actual. Su trabajo sobre la teoría de la información ha sido fundamental para el desarrollo de internet, las comunicaciones móviles, las computadoras y todo tipo de sistemas que transmiten datos.